一家名为D-Matrix,专注于为数据中心设计和构建高效芯片和生成人工智能计算平台的初创公司今天宣布,在由新加坡全球投资公司淡马锡牵头的超额认购 B 轮融资中筹集了 1.1 亿美元。

据报告,现有的投资者 Playground Global、微软公司的 M12 风险基金、Nautilus Venture Partners 和 Entrada Ventures 也参与了本轮融资,新投资者包括 Industry Ventures、Ericsson Ventures、Marlan Holdings、Mirae Asset 和 Samsung Ventures。

D-Matrix在 2022 年 4 月的一轮融资中获得了 4400 万美元,由 M12 和韩国半导体制造商 SK 海力士公司领投。该轮融资使该公司的融资总额达到 1.54 亿美元。

M12 的 Michael Stewart 表示:“我们正在进入生产阶段,LLM 推理总拥有成本将成为决定企业在其服务和应用程序中使用先进人工智能的程度、地点和时间的关键因素。”

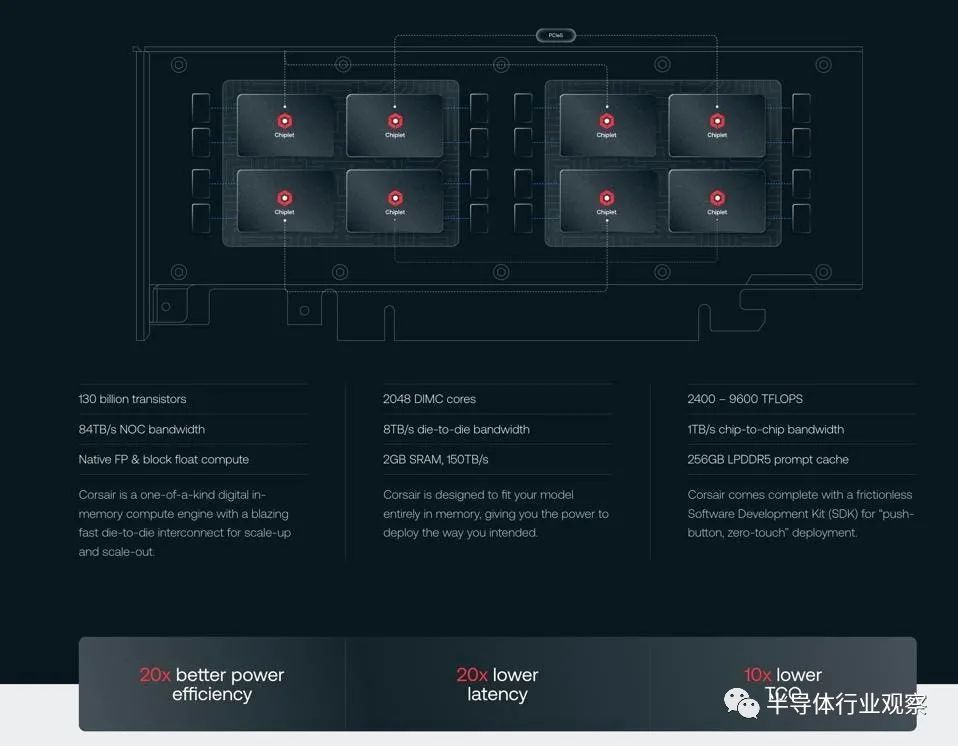

Sheth 表示,D-Matrix 计划将新资金投资于其Corsair 平台的招募和商业化,该平台使用 DIMC 架构和小芯片,以降低推理成本。Corsair 计划于 2024 年推出,是一款 PCI 外形卡,可与机器学习工具链和用于生产的服务器软件配合使用,这些软件主要由广泛采用的开源软件构建。只需“按一下按钮”,人工智能模型就可以快速导入卡中,无需重新训练。

Sheth 表示:“由于推理成本高昂,目前生成式人工智能的前景还无法实现,而通过今天的公告和我们的资金注入,我们将能够比该领域的其他任何人更快地将商业上可行的解决方案推向市场。”

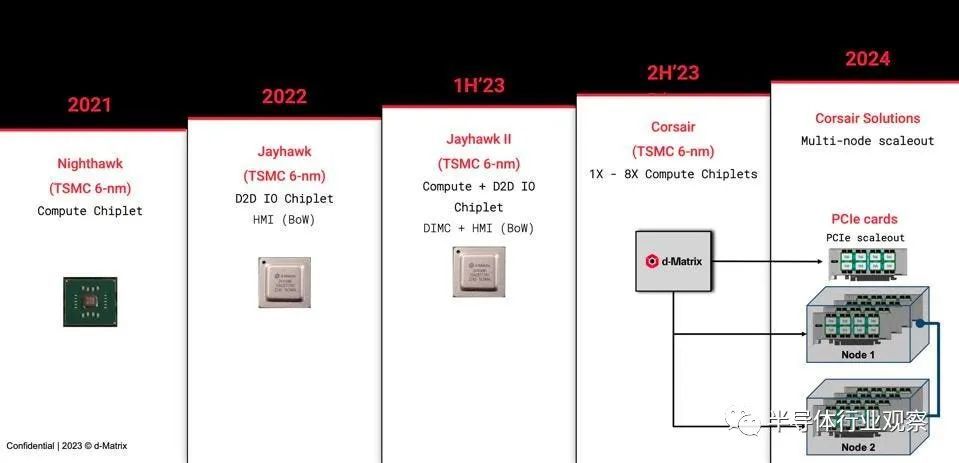

此次融资公告是在上个月推出 d-Matrix Jayhawk II 小芯片之后发布的,该小芯片采用增强型 DIMC 架构。d-Matrix 表示,通过这个基于小芯片的新平台,其客户可以获得比图形处理单元高 10 到 20 倍的效率,并节省 10 到 20 倍的成本。

虽然令人兴奋的说法,但我们更希望 d-Matrix 使用行业标准的 MLPerf 同行评审基准来证实这些说法,希望这会在适当的时候出现。

d-Matrix,什么来头?

资料显示,d-Matrix 是一家总部位于硅谷的公司,为生成式人工智能和大型语言模型生产计算平台(芯片)。其旗舰产品是 Corsair,这是一款用于人工智能推理的内存计算引擎。该设计能够将人工智能模型完全保存在内存中,这一点很新颖,并且建立在 d-Matrix 之前的 Nighthawk、Jayhawk-I 和 Jayhawk II 小芯片的基础上。

d-Matrix 之所以脱颖而出,是因为芯片制造领域竞争激烈,而且许多小公司在融资方面遇到困难。英伟达已经迫使许多小公司和投资者退出人工智能芯片市场。路透社称,特别是英伟达在硬件和软件方面的主导地位使得其他公司难以挤入。

d-Matrix之前曾经发布新闻稿表示,随着大模型推动人工智能推理需求不断扩大,而内存和能源需求达到阈值限制,d-Matrix 正在将首款基于 DIMC 的推理计算平台推向市场。d-Matrix 通过一个可扩展的平台改变了复杂变压器和生成式人工智能的经济性,该平台旨在处理推理人工智能的海量数据和电力需求,使高耗能的数据中心更加高效。

d-Matrix 的这款新颖的 AI 计算平台巧妙地结合了智能 ML 工具和集成软件架构,利用乐高块网格形式的小芯片,从而能够将多个编程引擎集成在一个通用包中。

将 d-Matrix 技术与 Project Bonsai (微软低代码强化学习平台 Project Bonsai )相结合,可以为 DIMC 平台高效创建编译器。Project Bonsai 加速了编译器堆栈中训练有素的 RL 代理的快速原型设计、测试和部署,以充分利用 d-Matrix 的低功耗 AI 推理技术,该技术可提供比旧架构高出十倍的能效。

d-Matrix 联合创始人兼首席技术官 Sudeep Bhoja 表示:“d-Matrix 构建了世界上最高效的大规模 AI 推理计算平台。” “Project Bonsai 吸引我们的原因是其产品至上的功能和易用性。Microsoft 的独特产品是围绕机器教学和 Inkling 语言构建的,这使得 RL 构造可以完全解释。”

基于 RL 的编译器预计将成为 d-Matrix 的第一代 DIMC 产品 CORSAIR 的关键差异化因素,该产品预计将于 2023 年末推出。

“我们一直在共同开发基于强化学习的编译器,”微软Project Bonsai团队首席应用人工智能工程师 Kingsuk Maitra 说道。“我们从一开始就重视产品思维。包括指令集架构的实施例已在两个 d-Matrix 测试芯片 NightHawk 和 JayHawk 上经过审查和验证,并嵌入到 RL 训练环境中。Project Bonsai 的低代码属性使早期开发工作变得容易,并且能够集成统计控制参数并使其他现实生活芯片设计约束的集成更简单,迄今为止取得了非常有希望的结果。”

d-Matrix 联合创始人兼首席执行官 Sid Sheth 在公司新一轮融资新闻稿中表示:“人工智能计算目前的发展轨迹是不可持续的,因为运行人工智能推理的总拥有成本正在迅速上升。” “d-Matrix 团队正在通过专为LLM构建的计算解决方案改变部署人工智能推理的成本经济,这一轮融资验证了我们在行业中的地位。”

生成式人工智能大型语言模型,例如 Meta Platform Inc. 的 Llama 2 和 OpenAI LP 的 ChatGPT,通过接受大量文本数据的训练来工作,以便它们能够理解并用类似人类的语音进行“交谈”。训练需要大量的计算能力,但在部署前只需要进行一次。部署人工智能后,推理用于回答问题、总结文档等。

“生成式人工智能将永远改变人们和公司创造、工作以及与技术互动的方式,”该公司首席执行官 Sid Sheth 告诉 SiliconANGLE。“随着 ChatGPT 的发布,这一认识在‘大爆炸’时刻得到了具体体现。虽然 ChatGPT 等生成式人工智能模型的性能令人惊叹,但成本却令人震惊。”

D-Matrix 生产具有专用“小芯片”架构的芯片,该架构使用数字内存计算(DIMC)。这将完全可编程的存储器直接带入芯片,以减少推理处理的延迟,使其更快、更高效、更便宜。

使用小芯片,可以使用多个小芯片来构建更大、模块化和可扩展的集成电路。这两个流程相结合,使 d-Matrix 能够生产出各种平台,这些平台可以扩展用于生成 AI 推理任务,并提高性能和效率。

然而,我们不知道 Corsair 在较大型号上的性能如何,这些型号会溢出芯片上相对较小的 2GB SRAM。同样,当前可用的 LLM 推理解决方案使用 NVIDIA NVLink 4.0,速率高达每秒 900 GB (GB/s)。这是 PCIe Gen 5 带宽的 7 倍多,PCIe Gen 5 是托管 Corsair 加速器的服务器中使用的互连技术。我们的预感是,d-Matrix 将专注于适合的较小模型,而这些较小模型将成为企业采用生成式 AI 的驱动力。

Cambrian AI 分析师 Karl Freund 表示,尽管 d-Matrix 是 AI 计算和推理市场的初创公司,但仍与 AI 硬件/软件巨头 Nvidia 竞争。

虽然 Nvidia 在人工智能芯片市场上处于领先地位,但 D-Matrix 提供了一个内存计算平台,Freund 表示该平台应该速度快且成本低得多,因为它没有高带宽内存,而是使用静态随机存取内存。

“只有少数公司真正有机会与英伟达竞争,”Freund 说。“D-Matrix 就是其中之一。他们使用不同的技术、不同的架构,似乎可以产生更好的结果。”

正是这种相信 d-Matrix 将比Cerebras 等其他初创公司持续更长时间的信念,吸引了早期投资公司 Playground Global 加入 d-Matrix。

该公司于 2019 年开始担任 d-Matrix 的顾问,并在该供应商的第一轮融资期间成为投资者。

风险合伙人 Sasha Ostojic 表示,与市场上众多初创公司相比,d-Matrix 因其团队、技术以及其试图解决的不断增长的人工智能市场而脱颖而出。

“我们在 D-Matrix 中看到的是,他们很早就把赌注押在了生成式 AI 和法学硕士上,”Ostojic 说。“他们打赌这将成为未来的主要工作负载,他们是对的。世界其他地方基本上都赶上了这种洞察力。”

此外,Freund 表示,市场可能会转向 d-Matrix 的低成本推理策略。

“现在推理成本太高了,”他说。

“这需要八个H100 或 A100 GPU才能完成推理过程,”他继续说道,指的是 Nvidia AI 芯片。“每次你回答输入一个查询时,都需要八个 GPU 来回答。这是不可持续的。”

d-Matrix 等公司将通过内存计算等技术帮助降低成本。Freund表示,甚至英伟达也可能很快发布价格更低的推理处理产品。

Freund 表示,d-Matrix 未来面临的挑战是如何在 Jayhawk II 开发平台上启动并运行其生成式 AI 模型。“客户想要更快、成本更低的解决方案,但他们不想经历导入和优化代码和模型的痛苦和痛苦,”他说。

Ostojic 表示,对于 Playground Global 来说,执行是 d-Matrix 下一步要解决的问题。

他说:“现在剩下的就是明年将生产芯片推向市场,并在数据中心和超大规模企业中部署企业级、无摩擦的软件堆栈。”据供应商称,D-Matrix 的小芯片预计将于 2024 年上市。