远程医疗,人工智能和深度学习正在彻底改变医疗保健(免费PDF)第二轮MLPerf基准测试结果为,提供了用于运行AI培训工作负载的工具的新的客观测量。通过Nvidia,谷歌和英特尔的提交,结果显示了人工智能基础设施在数据中心和云中的改进速度。MLPerf是一个广泛的基准测试套件,用于测量机器学习(ML)软件框架(如TensorFlow,PyTorch和MXNet),ML硬件平台(包括Google TPU,Intel CPU和Nvidia GPU)和ML云平台的性能。几家公司以及哈佛大学,斯坦福大学和加州大学伯克利分校等机构的研究人员去年首次同意支持基准测试。目标是为开发人员和企业IT团队提供信息,以帮助他们评估现有产品并专注于未来的开发。

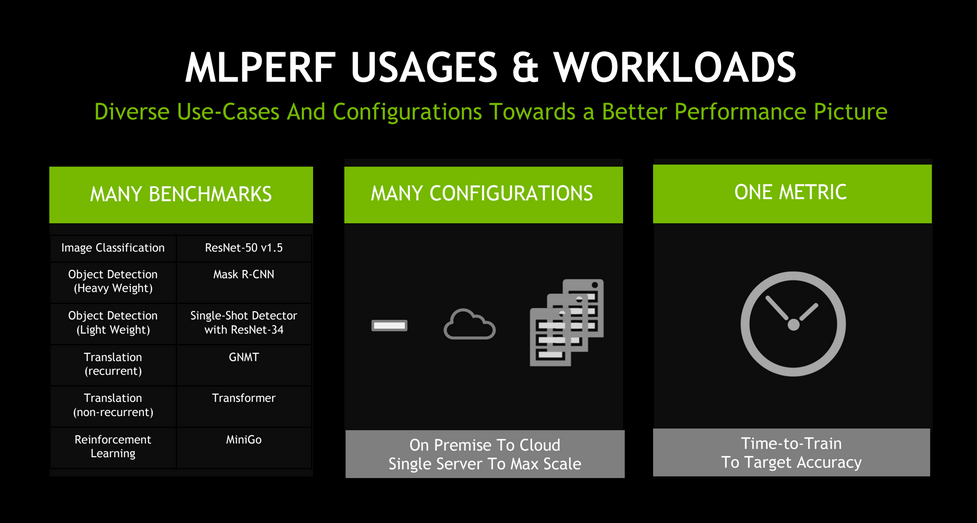

早在12月,MLPerf公布了第一批ML模型培训结果。度量标准是将模型训练到目标质量水平所需的时间。基准套件包括六个类别:图像分类,对象检测(轻量级),对象检测(重量级),翻译(重复),翻译(非经常性)和强化学习。

Nvidia是唯一一家在所有六个类别中提交结果的供应商。GPU制造商在培训表现方面创下了8项记录,其中包括三项大规模整体表现和五项基于加速器的表现。

在所有六个类别的大规模基础上,Nvidia使用其DGX SuperPod在20分钟内训练每个MLPerf基准。例如,使用Resnet-50 v1.5训练图像分类模型仅需80秒。就在2017年,当Nvidia推出DGX-1服务器时,该培训大约需要8个小时。

Nvidia加速计算主管Paresh Kharya本周告诉记者,短短几年内取得的进展“令人咋舌”。他说,结果证明了这个行业的发展速度。而且,这种速度有助于实现新的AI应用程序。

“人工智能的领导需要人工智能基础设施领导......研究人员需要继续前进,”Kharya说。

Nvidia强调其人工智能平台在重量级物体检测和强化学习方面表现最佳 - 以训练总时间衡量的最难的AI问题。

重量级物体检测用于自动驾驶等关键应用。它有助于为自动驾驶汽车提供行人和其他物体的精确位置。同时,强化学习用于训练机器人,或用于优化智能城市中的交通灯模式。

与此同时,Google Cloud进入了五个类别,并通过其云TPU v3 Pods- 谷歌的Tensor Processing Units(TPU)机架设置了三个大规模的性能记录。每个获胜的运行只需不到两分钟的计算时间。

结果使谷歌成为第一家超越运行大规模ML培训工作负载的内部部署系统的公共云提供商。

“机器学习有一场革命,”Google Cloud的Zak Stone向ZDNet表示,他指出深度学习和神经网络的突破是如何实现语言处理或对象检测等各种AI功能的。

“所有这些工作负载对性能至关重要,”他说。“他们需要如此多的计算,你的系统训练模型的速度真的很重要。等待一个月与几天之间存在巨大差异。”

在非经常性翻译和轻量级对象检测类别中,TPU v3 Pods训练模型的速度比Nvidia系统快84%。

虽然获奖作品在完整的TPU v3 Pod上运行,但Google客户可以选择最适合其性能需求和价位的Pod“切片”大小。谷歌今年早些时候公开发布其云TPU Pods测试版。一些使用Google的TPU或Pod的客户包括openAI,Lyft,eBay和Recursion Pharmaceuticals。

可怕的智能技术:人工智能已经给出了9个实时......看完了全部画廊